В последние годы наблюдается бурный рост интереса к искусственному интеллекту (ИИ) и его потенциальному влиянию на общество. В этой связи по всему миру начали появляться институты, посвященные безопасности ИИ. Однако остается вопрос: действительно ли эти учреждения приносят пользу, или же они являются лишь частью растущего ажиотажа вокруг технологий?

Введение в проблему

ИИ стремительно развивается, и с его распространением увеличиваются и риски, связанные с его применением. Эти риски варьируются от угроз конфиденциальности и предвзятости алгоритмов до потенциальных опасностей, связанных с автономными системами. В ответ на эти вызовы в разных странах создаются институты безопасности ИИ, целью которых является изучение и минимизация потенциальных опасностей.

Цели и задачи институтов

Основная задача этих институтов заключается в проведении исследований, направленных на понимание и предотвращение рисков, связанных с ИИ. Они занимаются разработкой стандартов и рекомендаций по безопасному использованию ИИ, а также взаимодействуют с правительствами и бизнесом для внедрения лучших практик. Кроме того, такие институты часто становятся платформами для междисциплинарного взаимодействия, объединяя экспертов в области технологий, этики, права и общественных наук.

Примеры институтов

Среди известных институтов можно отметить такие организации, как Центр безопасности ИИ в Великобритании, Институт будущего жизни и Институт машинного интеллекта в США. Эти учреждения активно работают над тем, чтобы ИИ приносил пользу обществу, минимизируя при этом возможные риски.

Критика и скептицизм

Несмотря на благие намерения, некоторые эксперты выражают скептицизм относительно реальной эффективности таких институтов. Критики утверждают, что многие из них занимаются исследованиями и разработками, не имеющими практического применения. Кроме того, существует мнение, что часть из них может быть использована для лоббирования интересов крупных технологических компаний, а не для решения реальных проблем безопасности.

Важность международного сотрудничества

Одним из ключевых аспектов успешной работы институтов безопасности ИИ является международное сотрудничество. Угрозы, связанные с ИИ, не знают границ, и их эффективное решение требует координации усилий на глобальном уровне. Это включает обмен информацией, совместные исследования и разработку единых стандартов и регулятивных норм.

Заключение: полезны ли институты безопасности ИИ?

Хотя скептицизм относительно институтов безопасности ИИ сохраняется, их потенциальная польза для общества значительна. Эти организации играют важную роль в понимании и минимизации рисков, связанных с ИИ, а также в формировании этических и правовых норм. Однако для того, чтобы их работа была действительно эффективной, необходимо обеспечить прозрачность их деятельности и ориентированность на реальные проблемы. В конечном итоге, успех институтов безопасности ИИ будет зависеть от их способности адаптироваться к быстро меняющемуся технологическому ландшафту и сотрудничать на международном уровне.Таким образом, институты безопасности ИИ представляют собой важный шаг на пути к ответственному и безопасному использованию технологий, и их развитие следует приветствовать, несмотря на существующие вызовы и критические замечания.

Последние сообщения подтверждают, что правительство Индии предпринимает шаги по созданию Института безопасности искусственного интеллекта (AISI) для разработки стандартов, выявления рисков и создания руководящих принципов для ИИ. Сообщается, что институт также будет работать над международной координацией для обмена информацией о структурах ИИ и разрабатывать наборы инструментов, которые отрасль в Индии сможет использовать для оценки.

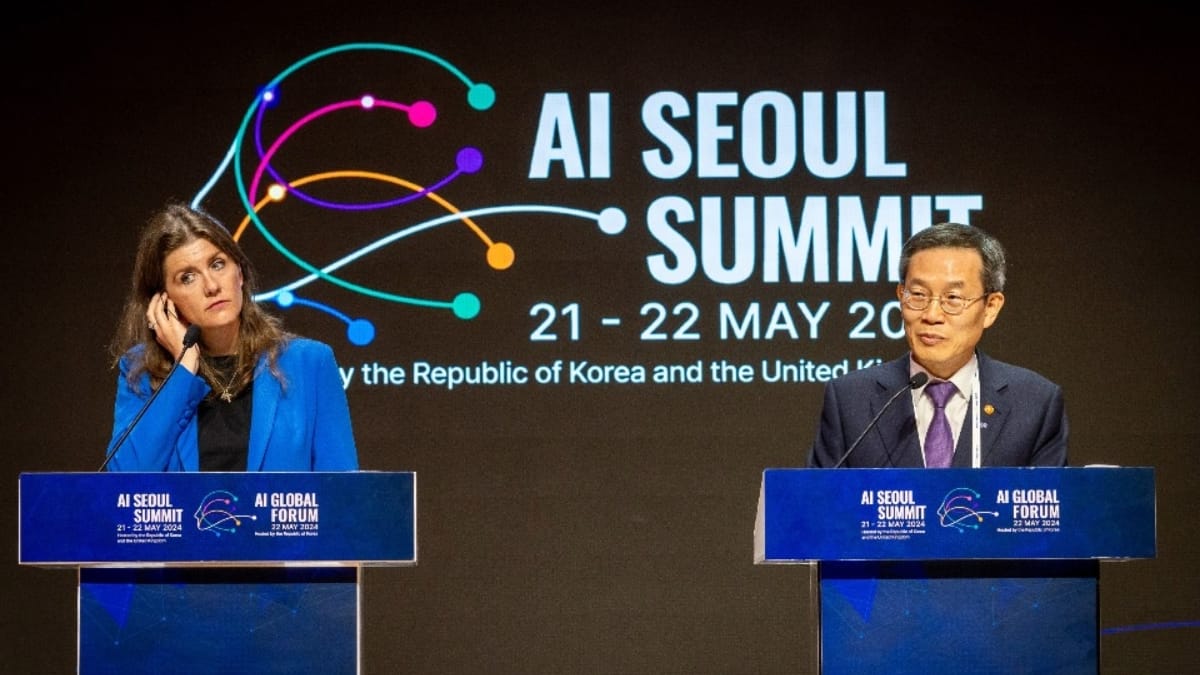

AISI не являются чем-то новым. За последний год несколько стран создали AISI. Правительство премьер-министра Великобритании Риши Сунака создало свой AISI в ноябре 2023 года при Министерстве науки, инноваций и технологий. США создали AISI при Национальном институте стандартов и технологий (NIST), который возглавляет бывший экономический советник администрации Байдена. На саммите по искусственному интеллекту в Сеуле в мае 2024 года было объявлено о создании международной сети по безопасности ИИ, в которую вошли десять стран и Европейский союз. Целью сети, помимо прочего, является обмен знаниями об инцидентах и рисках, связанных с ИИ.

Безусловно, ИИ-системы могут приносить пользу. Учитывая стремительное развитие технологий ИИ и вариантов их использования, новые формы причинения вреда, использование персональных данных для обучения моделей ИИ и проблемы с авторскими правами, среди прочего, разработка основ для безопасного и надёжного ИИ имеет первостепенное значение. Обмен информацией для разработки эффективных стандартов и рекомендаций по безопасности, изучение проблем предвзятости или дискриминации, а также проведение исследований — всё это желательные цели для обеспечения устойчивых инноваций.

Подчиняться или не подчиняться: выбор за вами

Несмотря на то, что AISI выглядят многообещающе, возможные проблемы связаны с тем, что эти модели в значительной степени ориентированы на принятие добровольных стандартов и саморегулирование. В Индии, как и в других странах, в настоящее время предлагается, чтобы AISI не обладала какими-либо регулирующими или правоприменительными полномочиями, а только проводила исследования и разрабатывала предлагаемые структуры, которые отрасль могла бы либо соблюдать, либо нет. По сути, стандарты AISI не должны быть обязательными.

Такой подход используется в США и Великобритании. В Великобритании даже говорят, что AISI «не является регулятором и не определяет государственное регулирование». Аналогичным образом, в США, поскольку AISI подчиняется NIST, принятие стандартов частным сектором является добровольным. Японская AISI преследует аналогичные цели.

Что касается Индии, то это согласуется с предыдущими заявлениями Министерства электроники и информационных технологий. Министр информационных технологий ранее заявлял, что «жёсткое» регулирование ИИ — это не то, что нужно Индии, и что более мягкое регулирование способствует развитию инноваций, как и в случае с законом о защите данных и телекоммуникациях. Секретарь министерства заявил, что регулирование ИИ «в идеале должно быть мягким, хотя вред, который он наносит, вызывает беспокойство». В то же время выпущенное правительством в начале этого года руководство по искусственному интеллекту вызвало много вопросов о его точных границах и законности.

Именно этот вопрос и возникает: насколько желателен этот толчок к саморегулированию и добровольному внедрению ИИ, если саморегулирование привело к нежелательным результатам в других областях?

Легкое прикосновение: палка о двух концах

Идея «мягкого регулирования» распространена, когда речь идёт о любых новых технологиях, и в Индии она постоянно звучит, когда обсуждается законодательство о защите данных в сфере регулирования телекоммуникаций, финансовых технологий и цифровой конкуренции. Однако такой подход не привёл к лучшим результатам. Если взять в качестве примера защиту данных, то в последние годы средняя стоимость утечки данных в Индии только выросла, а утечка личной информации пользователей происходит постоянно. Несмотря на эти опасения, в законодательстве Индии о защите данных предусмотрено широкое исключение для всех общедоступных данных, которые не подпадают под определение «персональных данных» и не подлежат защите, предусмотренной для персональных данных. Это хорошая новость для тех, кто хочет обучать модели с помощью веб-скрапинга общедоступных данных, но это негативно сказывается на конфиденциальности, когда регулирующие органы вызывают опасения по поводу конфиденциальности, связанные с такой практикой.

Что касается AISI, то подход «лёгкого касания» сопряжён с теми же рисками. Он может способствовать инновациям, поощрять компании внедрять методы, повышающие доверие к ИИ, и стимулировать международное сотрудничество. Однако, когда стандарты не являются обязательными, а у организации нет полномочий по регулированию, это, по сути, не приводит к значимому уровню контроля рисков и вреда.

По сравнению с другими отраслями, ИИ обладает более разрушительным потенциалом, учитывая его применение в сферах, которые оказывают большое влияние на нашу жизнь, — таких как здравоохранение, оценка кредитоспособности, работа и охрана правопорядка. В Индии опрос, проведённый в начале этого года, показал, что около 50% государственных и общественных организаций хотят внедрить решения на основе генеративного ИИ.

Стремление к тому, чтобы AISI в обозримом будущем стала основным органом, определяющим развитие ИИ, вызывает опасения по поводу «добровольного» характера их директив. По сути, это приводит к тому же результату, что и саморегулирование, поскольку компании, использующие системы ИИ, могут сами решать, подходят ли им эти стандарты. В конечном счёте частные компании не подотчётны общественности, а значит, их решение о принятии определённых стандартов не проходит демократический контроль. Это выводит политику и регулирование в сфере ИИ за рамки общественных процессов с участием заинтересованных сторон, исключая их, и создаёт непрозрачность в принятии решений, когда процессы, лежащие в основе решений, касающихся людей, использующих ИИ, должны быть прозрачными, возможно, даже в большей степени, чем любая другая технология. Это особенно актуально для Индии, где высказывались опасения по поводу влияния ИИ на сам демократический процесс.

К регулированию искусственного интеллекта зубами

База данных инцидентов, связанных с ИИ, и мнения экспертов демонстрируют проблемы, связанные с подходом к саморегулированию. Хотя на первый взгляд они могут способствовать инновациям, в долгосрочной перспективе они, скорее всего, увеличат риски.

Это не значит, что АИИ — бесперспективное направление. АИИ могут быть конструктивными институтами, дополняющими регулирующие органы с полномочиями по обеспечению соблюдения законодательства. Например, Европейское управление по искусственному интеллекту придерживается в целом тех же взглядов, что и АИИ в Великобритании, США и Индии, но с той разницей, что оно может выступать в качестве дополнительного органа по обеспечению соблюдения Закона ЕС об искусственном интеллекте. Он может расследовать нарушения, создавать консультативные органы для реализации Закона об искусственном интеллекте, применять делегированные полномочия, проводить проверки моделей искусственного интеллекта, запрашивать информацию и меры у поставщиков моделей и применять санкции. Наряду с этими полномочиями он также стремится развивать международное сотрудничество и разрабатывать рекомендации, кодексы поведения, инструменты и контрольные показатели.

Что касается по сравнению с подходом Великобритании, которая разработала ‘межотраслевые принципы’ для внедрения существующими регулирующими органами (без предоставления каких-либо новых полномочий), подход ЕС, похоже, не ставит регулирование в зависимость от инноваций. Исполнительный указ администрации Байдена также является примером сочетания принципов, основанных на инновациях, с некоторыми конкретными мерами, хотя добровольные обязательства остаются основным элементом политики в области искусственного интеллекта. Также стоит отметить, что FTC была невероятно активным регулятором в cборьбе с вредом, связанным с искусственным интеллектом.

Судя по имеющейся у нас информации, индийский AISI, по-видимому, придерживается значительно более «свободного» подхода к регулированию. Кроме того, в стране нет регулирующих органов, которые одновременно занимались бы правоприменительной деятельностью, связанной с ИИ. Полномочия регулирующих органов, таких как предлагаемый Совет по защите данных (который мог бы заниматься пересечением сфер ИИ и конфиденциальности), также были значительно ослаблены в нынешнем законодательстве по сравнению с предыдущими проектами. Таким образом, индийский AISI, по-видимому, какое-то время будет единственным руководящим органом. Однако для ориентированного на человека ИИ, разработка которого основана на подотчётности, прозрачности и безопасности, нам нужны ресурсы и бюджеты для регулирования с реальной властью.